Me he pillado este portátil Lenovo IdeaPad Gaming 3 15IAH7 RTX3050Ti y un monitor externo BenQ Mobiuz EX2710R. El portátil tiene Windows 11. Tengo el siguiente problema, a ver si me podéis echar una mano.

- Conecto el portátil y el monitor, ambos por HDMI: Miro el adaptador que usa el monitor e indica que la RTX3050Ti

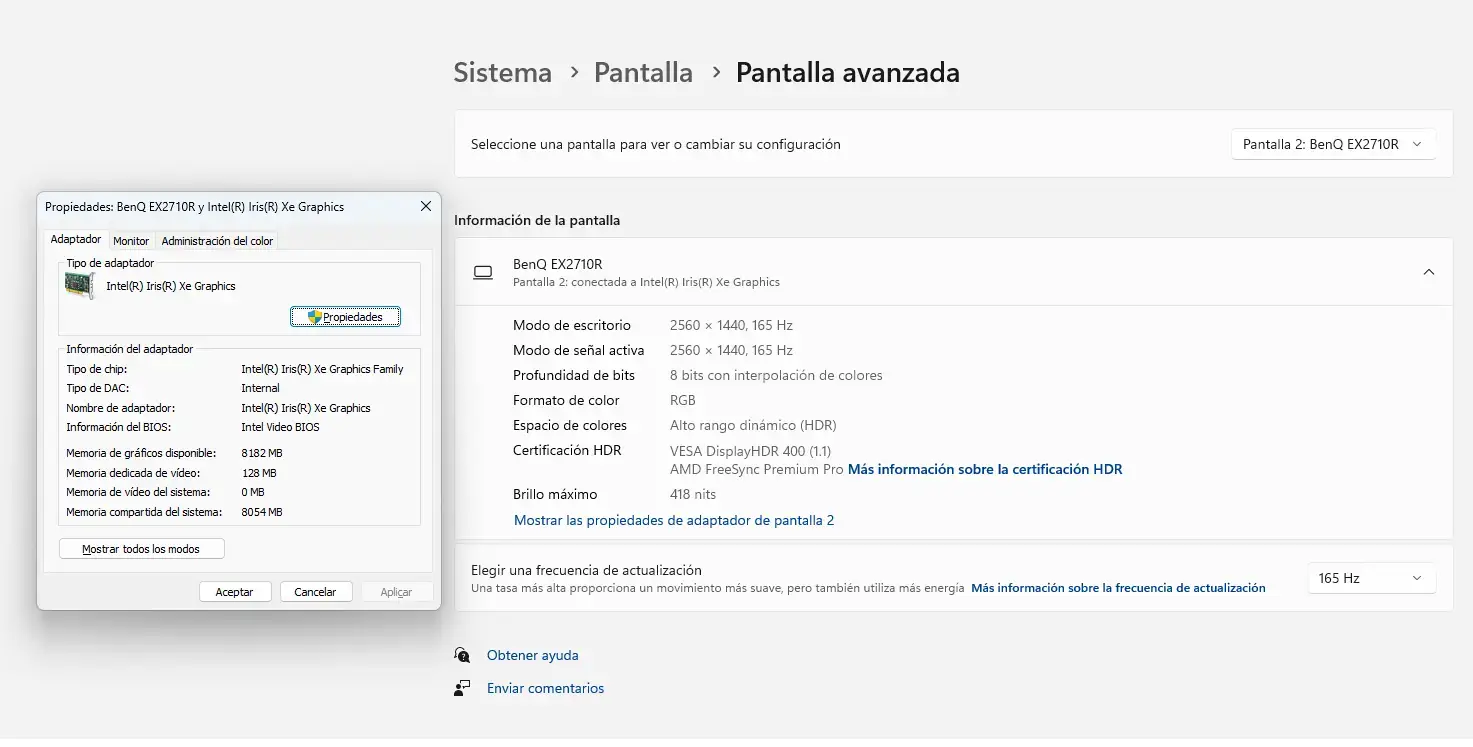

- Conecto el portátil (USB-C) al monitor (DisplayPort): El adaptador que usa el monitor es la IrisXe integrada

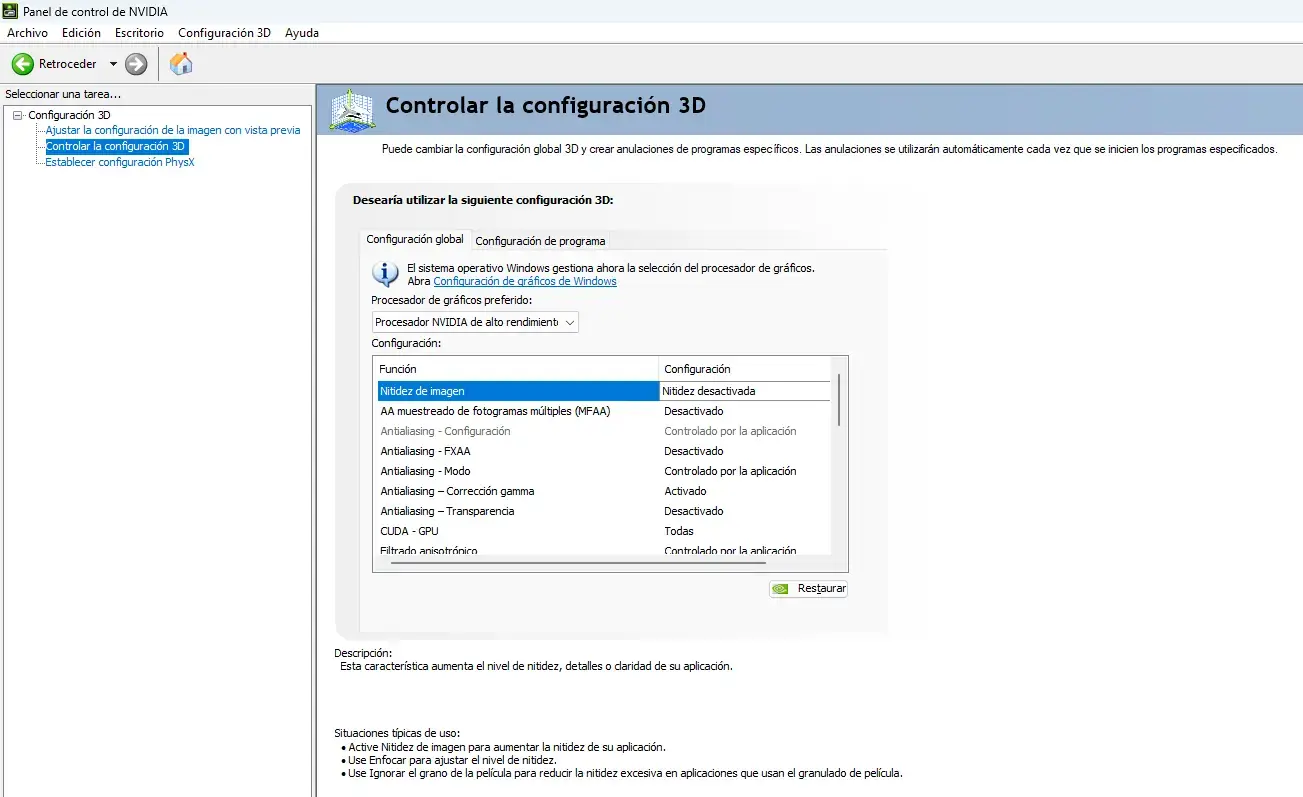

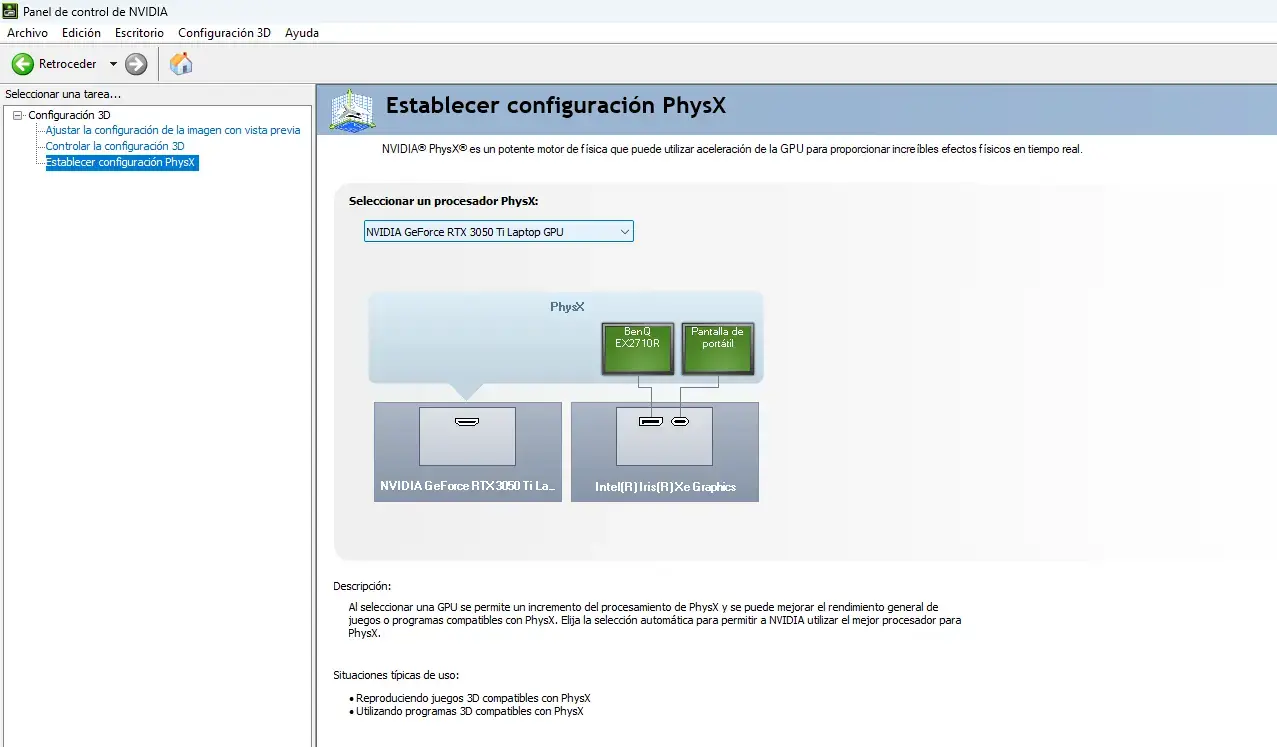

Ya he mirado la configuración en el panel de Control de NVIDIA, poniendo tanto en:

- Configuración 3D → Controlar la configuración 3D → Configuración global → Procesador de gráficos preferidos: Procesador NVIDIA de alto rendimiento

- Establecer configuración PhysX → procesador physX: NVIDIA GeForce RTX 3050Ti

Pero estos cambios no me han valido para que el adaptador que use el monitor sea la RTX.

He actualizado controladores y demás.

¿Qué puede estar pasando? ¿Es que el USB-C del portátil es sólo válido para la señal de la IrisXE y el HDMI si pilla la RTX?

Las imágenes son de cuando está conectado usando USB-c/DisplayPort