El caso es que por entretenerme, estaba pensando en pasar algunas pequeñas aplicaciones que tengo de Windows Forms a consola.

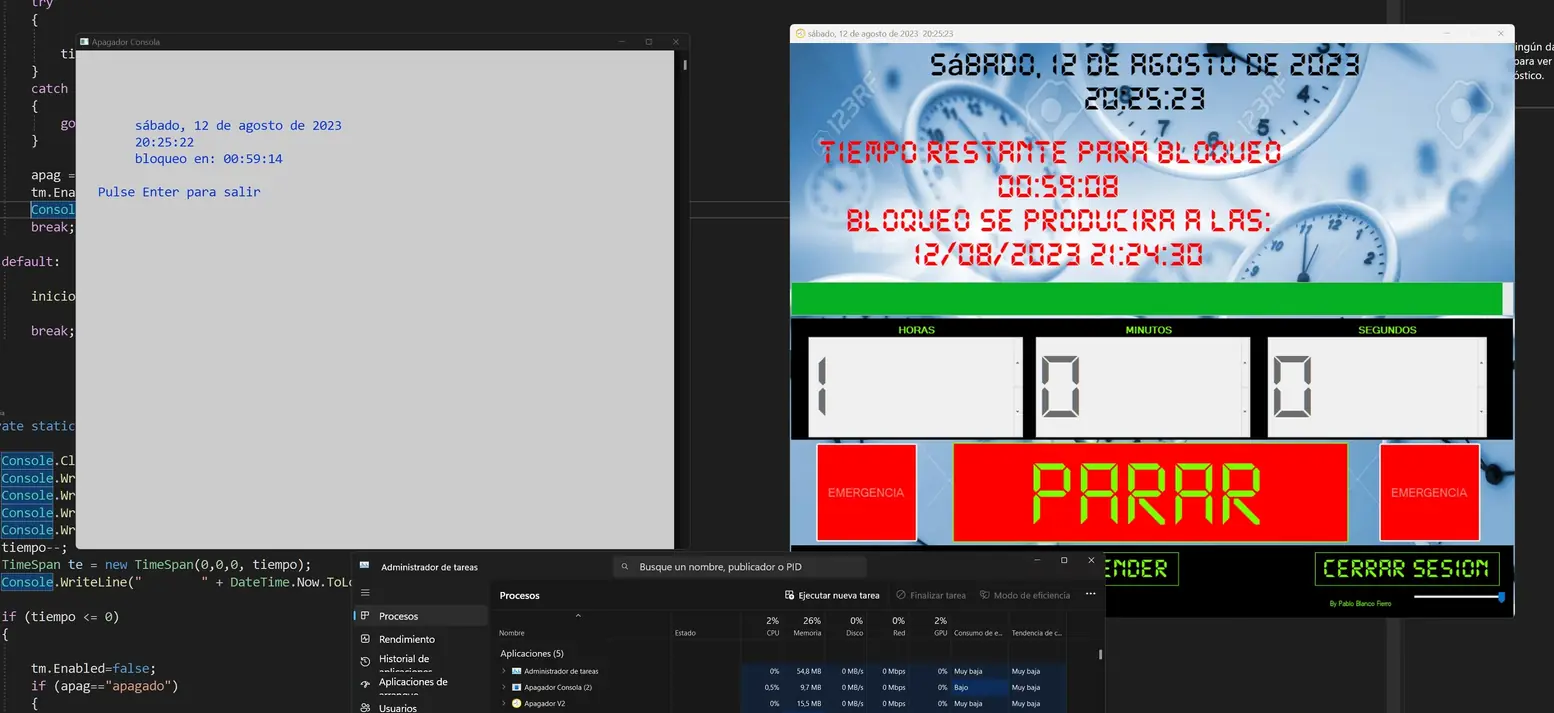

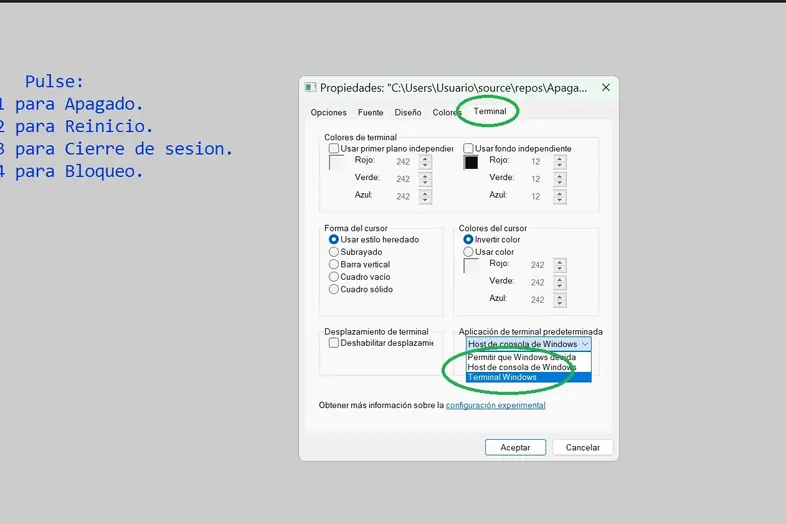

Cual es mi sorpresa que una sencilla aplicación para elegir el tipo de apagado del PC hecha para consola y que va sacando el tiempo que queda para el apagado con un timer, consume hasta un 1.5 %, mientras que una bastante mas compleja hecha con un Form se mueve entre un 0 y un 0.5. Esto ocurre tanto con compilación 32 como 64 bits.

¿A qué puede deberse esto? No es que tenga mucha importancia, pero me reconcome que en principio debiera ser al revés.